今天给大家带来的是Controlnet使用篇之Openpose篇教程。

Openpose就是传说中那个可以指定人物姿势动作的神奇控件。

在此之前,如果要指定人物姿势动作,基本上需要在prompt提示词写很详细,或者用图生图加上详细的prompt才能小概率生成满意的姿势。

而如果是一些稍微复杂一些的动作,几乎只能开盲盒了,很难控制,效率特别低。

而现在,只要用contolnet,就能精确控制人物姿势了,可以说,AI绘图可控性又前进了一大步。

那么,怎么使用呢?

一.

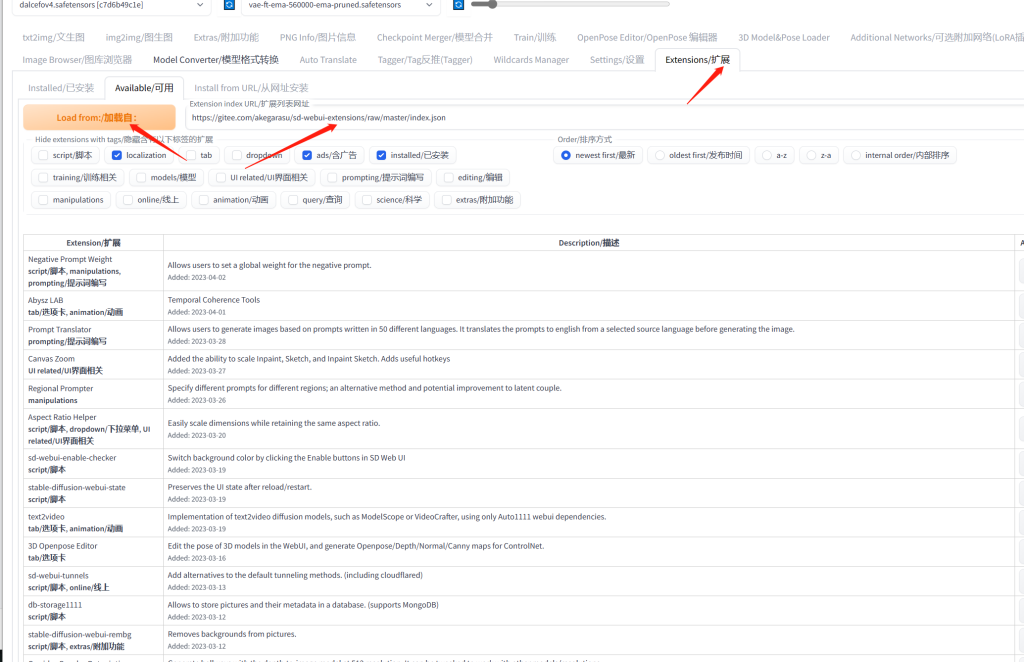

1.首先,你需要已经安装stable diffusion webui程序,ControlNet插件,下载好了Openpose模型。

网址:https://gitee.com/akegarasu/sd-webui-extensions/raw/master/index.json

找到sd-webui-controlnet/ControlNet 插件,在最后选择安装install,之后重启webui

2.打开stable-diffusion-webui。

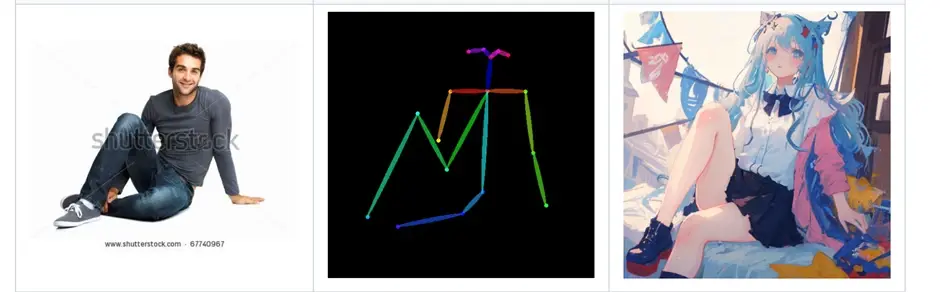

3.找一张人体姿势比较复杂的图

正脸上半身美女我们已经见太多了,姿势动作非常单一,看多了就审美疲劳了。

我网上随便找一张相对少见点的姿势,考考controlnet的效果。

4.稍微裁剪一下,让人物更大一点。

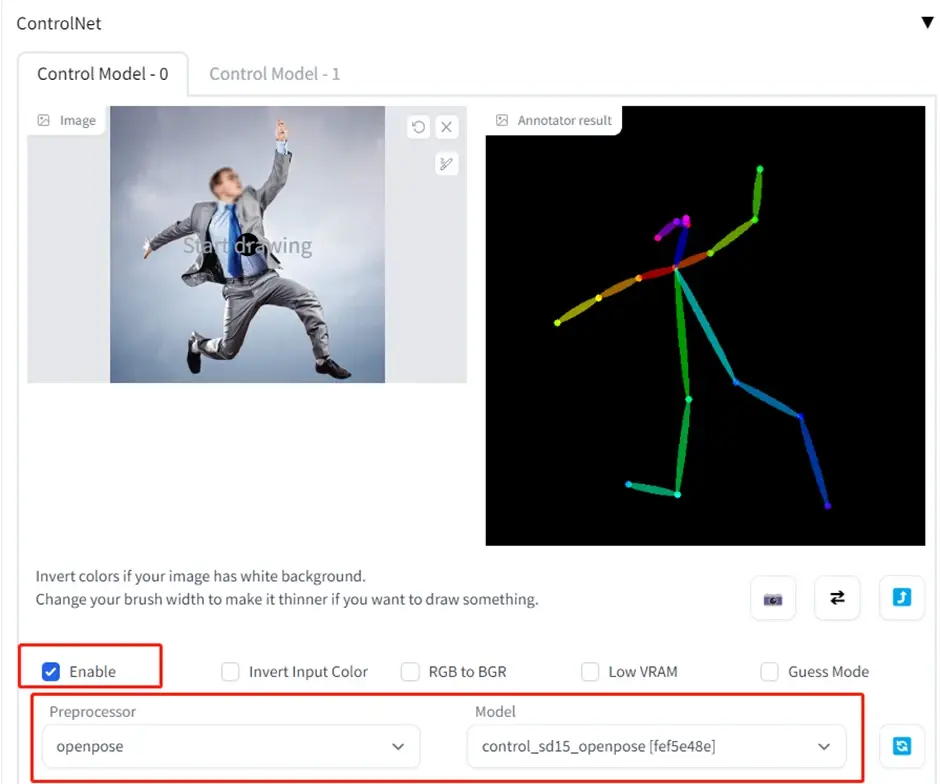

5.把图片放进controlnet,Enable打开,预处理器选择openpose,引导模型选择openpose,然后点击Preview annotator result按钮,生成预处理预览图。

6.看预览的骨架图,识别还算精确。

(找的图最好是真人,不要动漫,识别会准一点。如果识别出来的动作不对,则要换图,或者用openpose插件手动调整骨架的节点。文章后半部分有样例。)

7.接下来,准备要生成图片了。

基础模型选动漫类模型。

(这里建议选择漫画类模型,真人模型感觉姿势库可能少一些,效果不是很好)。

Prompt提示词我就写“girl,jump”(女孩,跳跃)。

8.然后点击generate生成按钮。

可以看出来,虽然一些细节还是表现不太好,比如手部,脚掌鞋子等。但姿势还是比较还原的,已经算是很强了。

(如果要优化局部的话,可以用inpaint功能重绘一下,或者自己用PS调整一下细节。)

注:

Controlnet插件对显卡性能要求较高,除了需要加载ckpt基础模型,还要加载controlnet预处理模型,和引导模型,建议显卡6G以上显存。

Controlnet使用时会经常爆显卡,显示显存不足,尤其是显存较小的同学。

显示显存不足时就不会有引导效果,所以你会感觉controlnet没用,不像。

解决办法是可以勾选low VRAM选项,同时有时候可能要重启webui以便释放显存。还有一种处理办法就是降低画布canvas和生成图片的长宽。以节省显存,避免报错。